基于知识图谱的信息抽取技术综述

一、背景

随着信息时代的到来, 数据呈爆发式的增长, 如何从这些数据中通过智能技术自动提取出真正有价值的信息尤为重要。知识图谱是一类知识表示, 由实体、关系以及属性构成。知识图谱的构建过程: 首先从数据源中提取出碎片化事实, 然后对碎片化事实进行知识的融合, 再经过知识加工后通过迭代更新建立基于知识的体系显然, 知识图谱的构建过程包括: 信息抽(information extraction), 知识融合, 知识加工等。信息抽取作为知识图谱的主要组成, 从数据源中抽取出实体和实体之间的关系等结构化信息包括对实体、关系以及事件等方面的抽取。

1.面临的问题

知识图谱中的信息抽取面对着 3 个挑战:

(1).第一, 如何从需要构建知识图谱的领域语料中利用启发式的信息来发现语料中的隐含知识, 从而在较少的人工标注中获得较高的准确度。

(2).第二, 如何解决已有知识图谱中部分不完整的实体、关系与事件信息所带来的噪声与语义漂移问题。

(3).第三, 如何在开放领域中利用现有的标注或加上较少的标注实现知识图谱在新信息中的完善与更新。

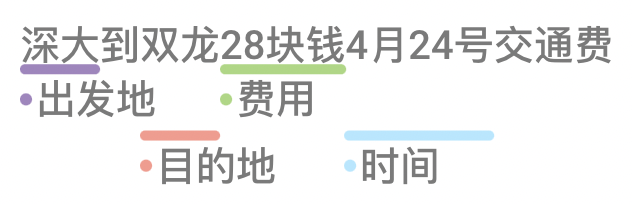

2.知识抽取的三个主要任务

(1).实体识别

(2).关系抽取

(3).属性抽取

二、实体识别

1.定义

命名实体识别 (named entity recognition, NER) 是实体抽取的别称。 命名实体能在具有相似属性的一组事物中清楚的标识出一个事物. 它可以理解为有文本标识的实体, 而实体 (entity) 是不依附于其他东西而存在的。

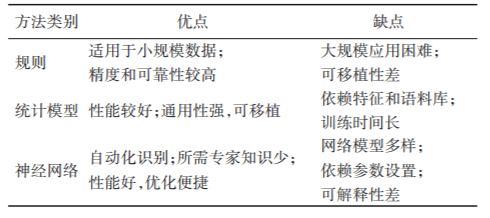

2.方法归类

NER三种识别方法

(1)基于规则和字典的方法

(2)基于机器学习-统计模型的方法

(3)基于深度学习-神经网络的方法。

近年来, 越来越多的研究者开始关注基于深度学习的NER方法.

这三种方式的对比

3.基于规则的方法

基于规则的方法通过专家手工构建规则集,将文本等数据与规则集匹配来得到命名实体信息。该方法在处理小规模的知识图谱时精度较高,但是随着知识图谱规模的增大,规则构建困难,且由于规则基于人工构建,难以进行大规模扩展并应用于不同领域的知识图谱。

4.基于机器学习-统计模型的方法

基于统计模型的方法将NER作为序列标注问题,以完全或部分标注的语料进行模型训练。常见的统计模型有条件马尔可夫模型(Conditional Markov Model,CMM)、隐马尔可夫(Hidden Markov Model,HMM)、条 件 随 机 场(Conditional Random Fields,CRF)和最大熵(Maximum Entropy,ME)等。基于统计模型的方法在构建一个新的领域知识图谱时需要做的改动较少,通用性强。

但是统计模型的状态搜索空间庞大、训练时间长,高度依赖特征选取和语料库,难以从海量数据中发现复杂且隐含的关键特征。

5.基于深度学习-神经网络

由于深度学习能够自动地从数据中学习复杂的隐藏特征,所需的领域专业知识和经验知识较少,基于神经网络的

NER 已 成 为 目 前 主 流 方 法 ,主 要 模 型 有 卷 积 神 经 网 络(Convolutional Neural Network,CNN)和 循 环 神 经 网 络(Recurrent Neural Network,RNN)等。

深度学习在实体抽取领域取得较好效果后, 研究人员开始在词汇级别上对其神经网络结构进行改进研究。

1.早期深度学习模型

模型偏重于词或字符的特征提取, 无法动态的表征上下文语境中的一词多义。主要有一下几种方式:

(1) Lample 等人[16]通过加入 CRF 模块以优化标签序列输出, 提出了 BiLSTM-CRF 模型, 在语料库上取得了比较高的 F1 值

(2) Ma等人[17]在双向 LSTM-CNNS结构上, 添加了 CRF 模块, 提出 BiLSTM-CNNs-CRF模型, 模型能同时利用词和字符级表示.

(3) Luo等人[18]提出了一种 Att-BiLSTM-CRF 模型, 该模型用于文档级实体识别, 在数据集上取得的 F1 值为 91.14%.

2.结合上下文语境或语义的模型

(1)Devlin 等人[19] 提出了 BERT 模型, 该模型可以使上下文语境或语义中的词得到充分的表征.

(2) Souza 等人[20]将 BERT-CRF 模型应用于葡萄牙 NER任务上, 获得了新的最佳 F1 值.

(3)谢腾等人[21] 提出一种 BERT- BiLSTMCRF 模型, 该模型在两个语料库上进行实验, 得到的F1 值分别是 94.65% 和 95.67%.

(4)百度推出了 ERNIE 模型[22], 该模型是通过加强 BERT的 masking 来获取知识. 实验表明, 在 5 项 NER 任务上, ERNIE 刷新了榜单.

(5)微软提出了一种多任务的训练方式的 MT-DNN 模型[23], 该模型比 BERT 更加稳定,泛化能力更好.

(6)由卡内基梅隆大学提出的 XLNet 模型[24]是一种通用的自回归预训练模型, 该模型解决了 BERT在预训练时加入 [MASK] 的 token, 从而导致 pretrain和 finetune 在训练数据上的差异.

(7)Liu 等人[25] 对 BERT的预训练进行了仔细的评估, 提出了一种能更好地训练 BERT 的方法, 称为 RoBERTa 模型, 该模型比 BERT之后的所有 psot-BERT 模型的效果好.

(8) Joshi 等人[26] 提出一种 SpanBERT 模型, 模型旨在更清晰的预测和表达文本跨度, 不再通过随机标记而是通过屏蔽连续的

随机跨度来使得 BERT 得到扩展.

(9)谷歌提出了 ALBERT模型[27], 该模型在 BERT 模型的基础上, 减小了两种参数量, 通过两个参数稍减技术克服了扩展预训练模型面临的主要障碍, 使得训练更加稳定.

三、关系抽取

关系抽取 (relation extraction, RE) 旨根据实体之间的上下文语境来确定语义关系, 它为许多下游任务提供了基础支持, 比如文本理解中, 为了理解复杂的语句,识别语句中的实体对之间的关系是至关重要的.在问答系统中, 关系抽取所得到的实体间的关系实例可以作为背景知识支撑问题的问答. 在 NLP 领域中, 关系抽取最重要的应用是构建知识图谱.

传统的关系分类模型需要耗费大量的人力去设计特征, 而且很多隐性特征也难以定义. 因此传统方法在

大规模关系抽取任务中效果不佳. 基于深度学习的关系抽取能够自动学习有效特征。

1.基于卷积神经网络的关系抽取

(1)Zeng等[42]首次提出使用CNN提取单词和句子级特征,形成特征向量预测关系分类。

2.基于循环神经网络的关系抽取

Socher 等[45]首次提出基于 RNN 的语义合成模型 MVRNN,学习任意长度的组合向量表示并用于名词间因果或主题信息等语义 关系分类 。

3.基于注意力机制的关系抽取

Attention-CNN[48]考虑文本中不同信息与实体的相关性,利用词嵌入信息,将文本段编码为语义信息,通过单词级ATT确定句子中的哪些部分对实体影响最大。

4.基于图卷积网络的关系抽取

C-GCN(Contextualized GCN)[52]

针对现有依存树模型在不同结构树下计算效率低、剪枝导致忽视信息等问题,提出基于GCN 和修剪依存树的关系抽取方法。

5.基于对抗训练的关系抽取

Wu等[55]首次提出在关系抽取中应用AT策略,Wang等[56]在此基础上,提出了 AMNRE(Adversarial Multi-lingual Neural Relation Extraction),以 AT策略保证对多种语言的句子表征,提取出语义一致的关系。

6.实体-关系联合抽取。

最早的实体-关系联合抽取方法是Miwa等[62]提出的堆叠双向树型LSTM-RNNs模型,在考虑实体信息的情况下进行关

系抽取。本质上,该方法的实体识别和关系抽取仍然是分离的.

四、属性抽取

1.定义

属性抽取是知识库构建和应用的基础,通过从不同信息源的原始数据中抽取实体的属性名和属性值,构建实体的属列表,形成完整的实体概念,实现知识图谱对实体的全面刻画。

2.方法分类

(1)传统的监督、无监督属性抽取

(2)基于神经网络的属性抽取和其他类型(如元模式、多模态等)的属性抽取。

1.传统的监督、无监督属性抽取

目前大部分属性抽取是从文本数据中抽取信息。传统方法中监督学习的属性抽取一般使用 HMM 和 CRF 等抽取属性。

(1)Raju 等[67]使用名词聚类方式,从名词类中抽取属性。

(2)Shinzato等[68]则提出一种无监督的属性抽取方式,自动对语料库质量进行注释,生成知识库。

2.基于神经网络的属性抽取

(1)基于神经网络的属性抽取一般作为序列标注任务,使用序列标注模型抽取文本中的属性值。如Zhao等[69]基于BERT预训练模型,使用 LSTM 结合 CRF 的序列标签模型抽取文本中的属性。

(2)基于元模式的属性抽取如Jiang等[70]提出的MetaPAD,将类型化的文本模式结构命名为元结构,可以在海量语料库中发现元模式。在属性抽取的场景中,能使用这种方法发现文本中高质量的属性描述语句,作为实体的属性值。

(3)Logan等[71]针对属性抽取大部分是基于文本数据的现 状 ,提 出 了 多 模 态 属 性 抽 取(Multimodal Attribute Extraction,MAE)方法及数据集,实现对多种类型数据(如图像、视频、音频等)的属性抽取。

五、统一抽取框架

1.目前抽取技术存在的问题

目前,大多数IE方法都是面向特定任务的,这导致了针对不同IE任务的专用体系结构、独立模型和专用知识源。这些任务专用解决方案极大地阻碍了IE系统的快速体系结构开发、有效的知识共享和快速跨领域适应。首先,为大量IE任务/设置/场景开发专用架构非常复杂。其次,学习孤立模型严重限制了相关任务和环境之间的知识共享。最后,构建专门用于不同IE任务的数据集和知识源既昂贵又耗时。

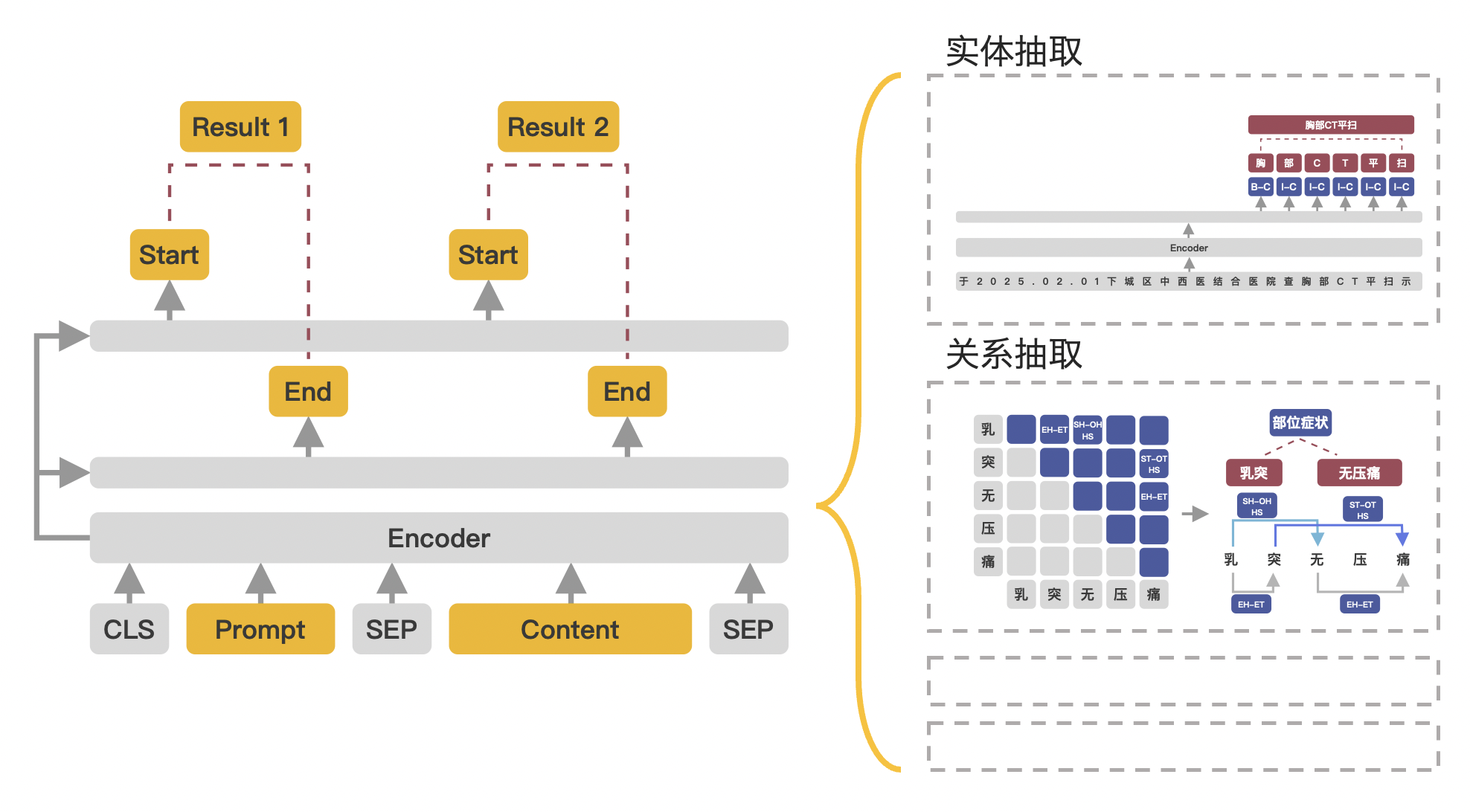

2.统一抽取框架-UIE

(1)论文地址:https://arxiv.org/pdf/2203.12277.pdf

(2)框架简介:

UIE-通用信息抽取(2022)。论文提出了一个统一的文本到结构生成框架,即UIE,它可以通用地建模不同的IE任务,自适应地生成目标结构,并从不同的知识源协作学习通用的IE能力。具体而言,UIE通过结构化提取语言对不同的提取结构进行统一编码,通过基于模式的提示(prompt)机制自适应生成目标提取,并通过大规模预训练的文本到结构模型捕获常见IE能力。实验表明,UIE在4个IE任务、13个数据集上,以及在所有有监督、低资源和few-shot设置上,对广泛的实体、关系、事件和情感提取任务及其统一,都取得了最先进的性能。这些结果验证了UIE的有效性、通用性和可移植性。

参考文献:

16.Lample G, Ballesteros M, Subramanian S, et al. Neural

architectures for named entity recognition. Proceedings of the 12016 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. San Diego: Association for Computational Linguistics, 2016. 260–270.

17.Ma XZ, Hovy EH. End-to-end sequence labeling via bidirectional LSTM-CNNS-CRF. Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics. Berlin: ACL Press, 2016. 1064–1074.

18.Luo L, Yang ZH, Yang P, et al. An attention-based

BiLSTM-CRF approach to document-level chemical named entity recognition. Bioinformatics, 2018, 34(8): 1381 –1388.

19.Devlin J, Chang MW, Lee K, et al. BERT: Pre-training of deep bidirectional transformers for language understanding.Proceedings of the 2019 Conference of the North American

Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long and ShortPapers). Minneapolis: Association for Computational Linguistics, 2019. 4171–4186.

20.Souza F, Nogueira R, Lotufo R. Portuguese named entity

recognition using BERT-CRF. arXiv: 1909.10649, 2019.

21.谢腾, 杨俊安, 刘辉. 基于 BERT-BiLSTM-CRF 模型的中文实体识别. 计算机系统应用, 2020, 29(7): 48–55. [doi: 10.15888/j.cnki.csa.007525]

22.Sun YS, Wang SH, Li YK, et al. ERNIE: Enhanced representation through knowledge integration. Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. ACL, 2019. 1441–1451.

23.Liu XD, He PC, Chen WZ, et al. Multi-task deep neural networks for natural language understanding. Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. Florence: Association for Computational Linguistics , 2019. 4487–4496.

24.Yang ZL, Dai ZH, Yang YM, et al. XLNet: Generalizedautoregressive pretraining for language Understanding.arXiv: 1906.08237, 2019.

25.Liu YH, Ott M, Goyal N, et al. RoBERTa: A robustly optimized BERT pretraining approach. arXiv: 1907.11692,2019.

26.Joshi M, Chen DQ, Liu YH, et al. SpanBERT: Improvingpre-training by representing and predicting spans.Transactions of the Association for ComputationalLinguistics, 2020, 8: 64–77. [doi: 10.1162/tacl_a_00300]

27.Lan ZZ, Chen MD, Goodman S, et al. ALBERT: A liteBERT for self-supervised learning of languagerepresentations. arXiv: 1909.11942, 2019.

42.ZENG D J,LIU K,LAI S W,et al. Relation classification via

convolutional deep neural network[C]// Proceedings of the 25th International Conference on Computational Linguistics:Technical Papers. Dublin: Dublin City University, Association for Computational Linguistics,2014:2335-2344.

45.SOCHER R,HUVAL B,MANNING C D,et al. Semantic compositionality through recursive matrix-vector spaces [C]//Proceedings of the 2012 Joint Conference on Empirical Methods in Natural Language Processing and Computational Natural Language Learning. Stroudsburg, PA: Association for Computational Linguistics,2012:1201-1211.

48.SHEN Y T,HUANG X J. Attention-based convolutional neural network for semantic relation extraction[C]// Proceedings of the 26th International Conference on Computational Linguistics: Technical Papers. [S. l.] : The COLING 2016 Organizing Committee,2016:2526-2536.

52.ZHANG Y H,QI P,MANNING C D. Graph convolution ove pruned dependency trees improves relation extraction [C]//Proceedings of the 2018 Conference on Empirical Methods inNatural Language Processing. Stroudsburg,PA:Association for Computational Linguistics,2018:2205-2215.

55.WU Y,BAMMAN D,RUSSELL S. Adversarial training for relation extraction[C]// Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing. Stroudsburg,PA:Association for Computational Linguistics,2017:1778-1783

56.WANG X Z,HAN X,LIN Y K,et al. Adversarial multi-lingual neural relation extraction [C]// Proceedings of the 27thInternational Conference on Computational Linguistics.Stroudsburg, PA: Association for Computational Linguistics,2018:1156-1166.

62.MIWA M,BANSAL M. End-to-end relation extraction using LSTMs on sequences and tree structures[C]// Proceedings of the54th Annual Meeting of the Association for ComputationalLinguistics. Stroudsburg, PA: Association for Computational Linguistics,2016:1105-1116.

67.RAJU S,PINGALI P,VARMA V. An unsupervised approach to product attribute extraction [C]// Proceedings of the 2009 European Conference on Information Retrieval, LNCS 5478. Berlin:Springer,2009:796-800.

68.SHINZATO K,SEKINE S. Unsupervised extraction of attributesb and their values from product description[C]// Proceedings of the 6th International Joint Conference on Natural Language Processing. Stroudsburg, PA: Association for ComputationalLinguistics,2013:1339-1347.

69.ZHAO G,ZHANG T,WANG C X,et al. Applications of BERT

based sequence tagging models on Chinese medical text attributesextraction[EB/OL]. (2020-08-22)[2020-12-11]. https://arxiv.org/pdf/2008. 09740. pdf.

70.JIANG M,SHANG J B,CASSIDY T,et al. MetaPAD:meta pattern discovery from massive text corpora[C]// Proceedings ofthe 23rd ACM SIGKDD International Conference on KnowledgeDiscovery and Data Mining. New York:ACM,2017:877-886.

71.LOGAN R L IV,HUMEAU S,SINGH S. Multimodal attribute extraction[C]// Proceedings of the 6th Workshop on Automated Knowledge Base Construction at NIPS 2017. Red Hook,NY:Curran Associates Inc. ,2017:No. 19.